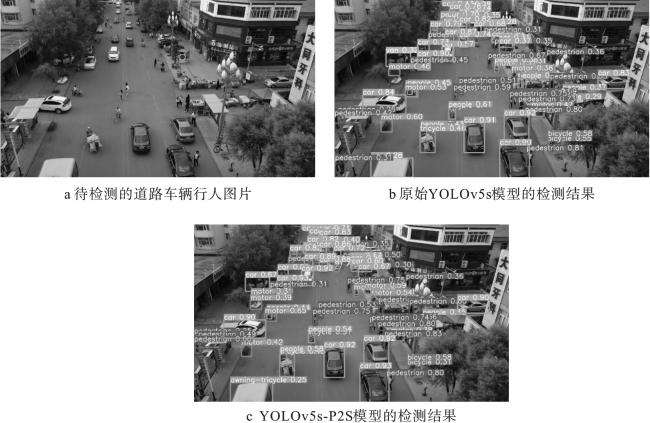

随着城市建设的快速发展,城市人口越来越密集,交通需求量也不断上升,道路交通压力逐步增加。在交通压力增加的同时,道路阻塞、安全事故频发等问题严重影响了人们的出行效率和生命安全

[1]。由于缺少对行人和非机动车的保护,他们成为了交通事故中的弱者,在参与交通活动时最容易受到伤害。对行人和非机动车的保护成为迫切需要解决的问题。

随着无人机技术的发展,无人机在各行业中的应用成为研究热点

[2]。无人机图像的目标检测与追踪技术能很好地帮助人们完成一些操作难度大、具有一定危险性、环境恶劣、空间狭小等情况下的工作,例如侦察敌情、交通疏导、物资投送、桥梁损坏勘测、地理测绘、电力设备巡检等

[3]。使用无人机进行机动车道上行人和非机动车检测能有效减少人工成本,实现对行人和非机动车的保护。由于无人机在使用时离地面较高,采集到的场景数据中的目标往往具有尺寸较小、形状复杂、容易受环境影响等特点,这些特点对目标检测模型优化设计提出了挑战。

随着深度学习的飞速发展,使用深度学习解决无人机视角下的目标检测问题成为一种更优的方案。2014年Girshick等

[4]首先将深度学习应用到目标检测算法,提出R-CNN算法,标志着目标检测从传统手工特征时代进入到深度学习时代。相比传统学习,通过深度学习可以获得更高的准确率和更快的检测速度。与传统学习相比,深度学习优势明显,国内外研究者纷纷放弃传统学习方向,加入到深度学习与目标检测结合的研究中。随着研究的深入,深度学习与目标检测的结合已经形成一套完整的体系。目前,主流目标检测主要分为两种

[5],一种是基于区域提议的两阶段目标检测方法,代表算法有R-CNN、Fast R-CNN

[6]、Faster R-CNN

[7]、Mask R-CNN

[8]等;另一种是基于回归的单阶段目标检测,其放弃了区域提议提取框,在保证检测精度的前提下,大幅度提高了检测速度。2016年Redmon等

[9]放弃了两阶段中“区域提议+回归”的检测模式,提出了第一个单阶段目标检测器YOLO,开启了经典的YOLO系列目标检测算法。2017年,Redmon等

[10]提出YOLOv2,丰富了单阶段家族,其使用Darknet-19作为骨干网络,将批量归一化层加入到每一个卷积层,从而使网络中各层的输入数据分布相对稳定,并使用

k-means对数据集进行聚类获得合适大小的锚框,其具有更高的精度和速度。2018年Redmon等

[11]对现有的一些经典结构进行整合提出YOLOv3,引入了残差网络模块,使用Darknet53作为主干网络替代Darknet19,去掉了池化层和全连接层,进一步加深网络层数。使用与FPN相似的特征融合策略,在高、中、低3个尺度上检测目标,能够更好地应对尺度差异较大的目标。2020年,Bochkovskiy等

[12] 提出的YOLOv4,使用Mosaic进行数据增强、CSPDarknet53作为主干网络、并使用Dropblock随机减少神经元数量,还使用SPP模块和FPN+PANet结构,充分利用语义信息和位置信息进行多尺度特征融合。同年6月YOLOv5出现,其根据参数量分为n、s、m、l、x 5种类型,这5种模型的网络结构一致,通过控制通道数和宽度来决定模型的参数量。随着通道数和宽度的增加,检测精度得到提高,但检测时间和消耗的资源也大幅提升。YOLOv5s是YOLOv5的小型版本,在保证精度的前提下训练速度较快,适合在CPU上进行推断。