(4)无人机搭载的硬件设备计算能力有限、存在一定成本开销,对模型的检测速度和轻量化有较高要求。Kisantal等

[8]通过复制粘贴小目标的操作来提高数据集中小目标的占比,从而提高小目标对网络的贡献。但这个操作仅增加小目标物体在数据集中的样本数量,并不能保证训练时正负样本数量平衡,而且没有对小目标的特征信息加以利用。Lin等

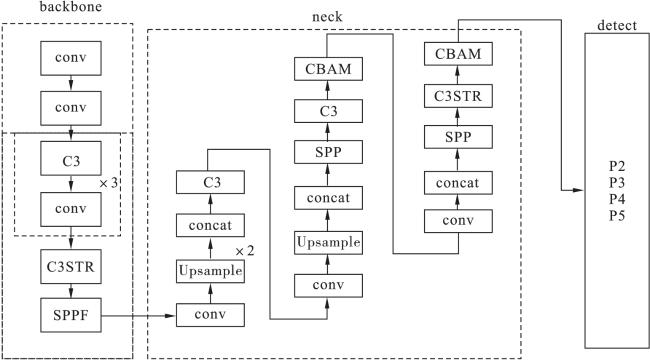

[9]提出经典的特征金字塔网络(feature pyramid network,FPN);Liu等

[10]提出路径聚合网络(path aggregation network,PAN),通过采用自上而下和自下而上的连接方式将不同层级的特征信息相融合,这种多尺度学习方法在一定程度上提高了网络的多尺度特征提取能力。但是仅通过简单的元素相加融合不同层级的特征图,忽略了不同层级的特征图拥有不同细粒度和价值的事实:浅层特征图的细粒度信息更有助于获取小目标的位置信息,而深层特征图的细粒度特征对语义信息的提取尤为重要。直接相加或者拼接操作还会导致冗余信息和冲突的产生,增加了网络参数量,减慢了训练速度。Yang等

[11]首先在低分辨率特征图上粗略地预测小目标的位置,然后用这些粗略的位置信息引导高分辨率特征图,更精确地计算出小目标位置。这样既可以得到更精确的预测回归,又可以对背景目标进行更少的计算。综上所述,虽然现有的小目标检测算法在一定程度上提高了检测性能,但仍存在一些不足:(1)前景和背景样本不平衡;(2)不同场景下目标特征捕获量不足;(3)为了提高精度而增加计算量和参数量,导致推理速度变慢,无法满足无人机实际部署应用;(4)模型的迁移能力弱,泛化性降低,适用性有限。