支持向量机(support vector machine,SVM)是一种基于统计学的VC(Vapnik Chervonenkis)维理论和结构风险最小化原理的机器学习方法,能较好地解决小样本、非线性、局部极小等实际问题,在模式识别和分类问题上具有良好的泛化性能。然而SVM对于噪声和异常值较为敏感,在产生分类决策面时易受其影响。Lin等

[1]将模糊数学的概念引入到SVM中,提出了模糊支持向量机(fuzzy support vector machine,FSVM)算法,通过对每个样本赋予一个模糊隶属值,使得不同的样本在构造分类决策面时的贡献不同。FSVM是一种代价敏感算法,可以在一定程度上克服噪声数据的影响,但是该算法不能有效地处理不平衡数据上的分类问题,该算法的隶属度计算仅依赖于原始数据空间中的中心点和初始超平面,可以很好地识别规则的单密集区域数据。然而,由于过度依赖中心点的计算,该算法在面对不规则或多个数据密集型区域时性能较差,一些改进的FSVM算法被相继提出。Fu等

[2]提出了一种新的基于相对密度的直觉模糊支持向量机(relative density-based intuition istic FSVM,RIFSVM)算法。利用相对密度来获取样本的先验信息,并通过引入直觉模糊评分函数进一步提高了模型对噪声或离群点的强识别能力,降低了类不平衡的影响。Kumar等

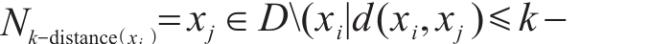

[3]提出了一种基于类内密度信息的模糊支持向量机(FSVM with within-class density information,FSVM-WD)算法,使用

k近邻距离的概念来估计类内相对密度,样本的隶属度被定义为

k近邻距离的倒数,具有较高的鲁棒性和容错性。Liu等

[4]提出了一种基于支持向量数据描述(support vector data description,SVDD)的模糊支持向量机算法(SVDD-based FSVM,FSVM-SVDD),噪声和异常点是由一个体积最小且包含最多样本的超球体来识别的,比SVM和FSVM具有更强的鲁棒性。Fan等

[5]提出了一种基于样本类确定性的模糊隶属度评价方法(entropy-based FSVM,EFSVM),利用熵来评价训练样本的类确定性,然后根据训练样本的类确定性来分配它们的模糊隶属度。与传统的 SVM 和 FSVM 相比,EFSVM 在不平衡数据集上能得到更灵活的决策面。Zhang等

[6]将信息熵与归一化的类中心距离相结合,得到模糊隶属函数,其中信息熵是基于

k近邻(

k-nearest neighbors,KNN)算法计算的。罗富财等

[7]将数据局部密度和数据特征距离引入模糊聚类,并将聚类得到的模糊隶属度作为模糊因子应用于模糊支持向量机,降低了人为选取模糊因子的主观性,将噪声点和孤立点对分类造成的影响降至最低。该方法使用KNN算法根据样本点之间的距离确定样本的局部密度。

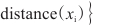

上述算法采用KNN算法选择近邻点时,通常使用欧氏距离或曼哈顿距离等标准来度量样本点之间的距离,从而确定样本之间的紧密度。这种方法在分类和回归问题中表现出色,尤其在样本分布均匀且类别界限清晰的情况下。然而,KNN算法在处理密度分散不均的数据时可能会遇到一些困难。当数据中存在不同密度的类簇时,使用统一的距离度量标准可能无法准确反映样本之间的真实紧密度。此外,KNN算法对噪声和异常值也比较敏感,因为它们可能会改变样本点之间的距离分布。对此,本文结合了文献[

8—

13]的异常数据识别方法,在设计模糊隶属函数时利用采样点及其邻域密度的相似性构建的离群因子(local outlier factor,LOF)获取数据的分布特征。相比之下,LOF算法关注的是每个样本点相对于其近邻点的局部密度偏差。因此,即使在不同密度的类簇中,LOF算法也能有效地识别出异常值和离群点。