1 检测网络框架结构

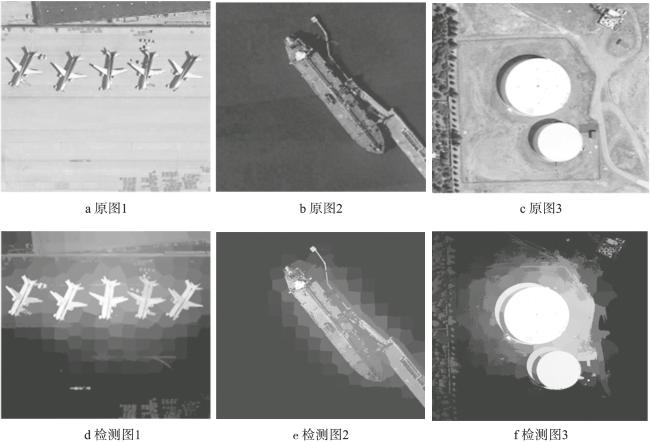

1.1 显著性引导的图像自适应融合

1.1.1 显著性引导检测

1.1.2 图像自适应融合

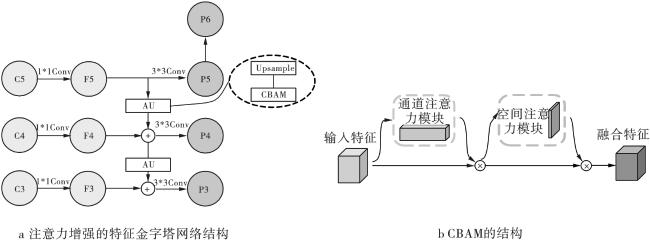

1.2 注意力增强特征金字塔网络

1.3 多尺度区域建议网络设计

2 实验结果与分析

2.1 数据集介绍

2.2 评价指标

2.3 实验参数设置

2.4 消融实验结果与分析

表1 在DIOR数据集上的消融实验结果 (%) |

| Num | Baseline | SGIAF | AMFPN | MRPN | P | R | mAP50 | mAP50:95 |

|---|---|---|---|---|---|---|---|---|

| 1 | √ | 67.0 | 58.6 | 61.6 | 43.1 | |||

| 2 | √ | √ | 71.2 | 60.6 | 64.1 | 44.6 | ||

| 3 | √ | √ | √ | 74.1 | 62.3 | 67.5 | 47.3 | |

| 4 | √ | √ | √ | √ | 76.6 | 65.3 | 69.8 | 49.3 |

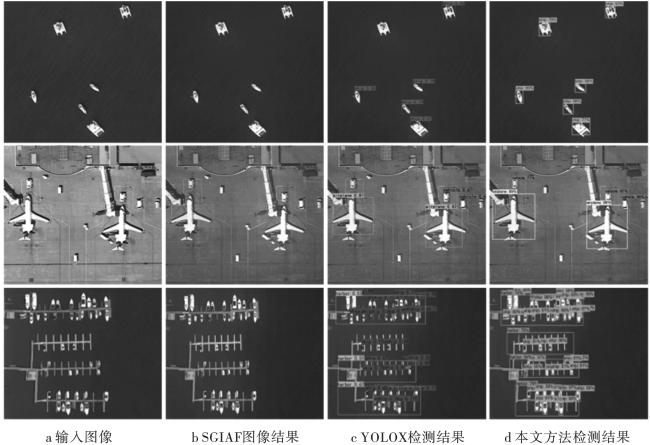

2.5 对比实验结果与分析

表2 不同检测算法在ROSD数据集上的 AP 比较 (%) |

| Method/Class | Faster-RCNN | SSD | YOLOv3 | YOLOv4 | Retinanet | YOLOv5 | YOLOX | FAOD | NAS-FPN | 本文 |

|---|---|---|---|---|---|---|---|---|---|---|

| Aircraft | 80.8 | 51.2 | 88.4 | 84.4 | 80.6 | 89.1 | 86.4 | 87.1 | 89.8 | 92.5 |

| Playground | 90.1 | 92.0 | 89.6 | 87.7 | 96.9 | 86.4 | 89.6 | 98.9 | 97.8 | 94.4 |

| Overpass | 78.7 | 53.7 | 86.9 | 73.8 | 90.3 | 80.4 | 88.4 | 56.6 | 92.5 | 89.1 |

| Oiltank | 90.2 | 98.4 | 88.9 | 95.6 | 96.7 | 97.2 | 95.4 | 97.9 | 89.4 | 99.1 |

| mAP50 | 84.5 | 73.8 | 88.4 | 85.4 | 91.2 | 88.3 | 89.9 | 85.1 | 92.4 | 93.8 |

表3 不同检测算法在DIOR数据集上的 AP 比较 (%) |

| Method/Class | Faster-RCNN | YOLO3 | Retinanet | YOLO5 | YOLOX | PANet | CF2PN | DETR | RAST-YOLO | 本文 |

|---|---|---|---|---|---|---|---|---|---|---|

| APL | 53.6 | 74.8 | 62.6 | 80.2 | 83.2 | 60.2 | 78.3 | 54.2 | 84.4 | 81.0 |

| APO | 49.3 | 73.0 | 72.2 | 62.2 | 74.8 | 72.0 | 78.3 | 77 | 73.7 | 79.6 |

| BF | 78.8 | 69.0 | 68.2 | 76.7 | 78.2 | 70.6 | 76.5 | 71.5 | 75.0 | 82.3 |

| BC | 66.2 | 87.5 | 84.8 | 86.8 | 83.8 | 80.5 | 88.4 | 87.1 | 85.7 | 81.9 |

| BR | 28.0 | 32.0 | 50.5 | 35.4 | 30.6 | 43.6 | 37.0 | 44.6 | 37.6 | 44.3 |

| CH | 70.9 | 75.1 | 76.7 | 74.2 | 76.5 | 72.3 | 70.1 | 75.4 | 76.7 | 86.8 |

| DAM | 62.3 | 48.2 | 54.5 | 37.4 | 47.8 | 61.4 | 59.9 | 63.5 | 51.8 | 54.5 |

| ETS | 69.0 | 56.5 | 56.4 | 59.4 | 54.4 | 72.1 | 71.2 | 76.2 | 60.0 | 61.6 |

| ESA | 55.2 | 47.7 | 47.1 | 55.6 | 58.9 | 66.7 | 51.2 | 65.3 | 56.4 | 56.5 |

| GF | 68.0 | 75.2 | 74.9 | 61.9 | 73.2 | 72.0 | 75.6 | 79.3 | 74.2 | 71.5 |

| GTF | 56.9 | 65.6 | 67.7 | 66.8 | 74.3 | 73.4 | 77.1 | 79.5 | 68.9 | 78.2 |

| HA | 50.2 | 53.8 | 42.7 | 56 | 42.6 | 45.3 | 56.8 | 47.5 | 61.3 | 51.2 |

| OP | 50.1 | 52.0 | 52.6 | 53.7 | 46.5 | 56.9 | 58.7 | 59.3 | 55.2 | 53.3 |

| SH | 27.7 | 73.2 | 68.0 | 89.3 | 92.7 | 71.7 | 76.1 | 69.1 | 90.3 | 72.4 |

| STA | 73.0 | 30.2 | 46.6 | 68.7 | 87.0 | 70.4 | 70.6 | 69.7 | 70.0 | 88.9 |

| STO | 39.8 | 70.2 | 47.1 | 75.3 | 71.1 | 62.0 | 55.5 | 64.3 | 75.9 | 80.8 |

| TC | 75.2 | 83.6 | 77.4 | 86.4 | 80.4 | 80.9 | 88.8 | 84.5 | 87.0 | 88.3 |

| TS | 38.6 | 48.6 | 40.0 | 42.3 | 41.3 | 57.0 | 50.8 | 59.4 | 54.8 | 37.6 |

| VE | 23.6 | 43.9 | 37.1 | 50.2 | 51.3 | 57.2 | 36.9 | 44.7 | 51.6 | 69.8 |

| WM | 45.4 | 72.3 | 71.9 | 74.8 | 70.4 | 74.5 | 86.4 | 83.1 | 75.9 | 74.4 |

| mAP50 | 54.1 | 61.6 | 59.0 | 64.8 | 65.9 | 66.1 | 67.3 | 67.8 | 68.3 | 69.8 |