1 相关工作

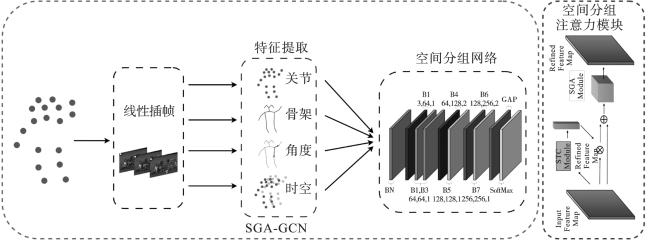

2 空间分组注意力图卷积网络

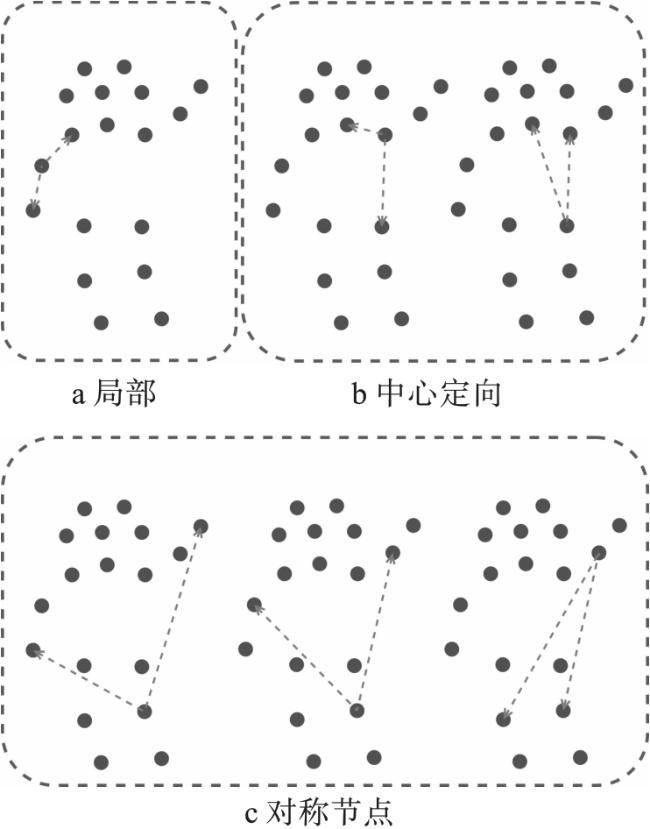

2.1 骨架图定义

2.2 空间分组注意力模块

2.3 骨骼角度的高阶特征编码

2.4 插帧策略

表1 线性插帧算法表 |

| 步骤 | 插帧算法 |

|---|---|

| Step 1 | , |

| Step 2 | |

| Step 3 | |

| Step 4 |

3 实验结果与分析

3.1 数据集

3.2 实验配置

3.3 实验方法与结果

3.3.1 参数量、训练及推理时长分析

表2 SGA-GCN模型与AAGCN的参数量比较 |

| 方法 | 参数量( ) |

|---|---|

| AAGCN | 3.78 |

| SGA-GCN | 2.51 |

表3 SGA-GCN模型与AAGCN的单轮训练时长比较 (s) |

| 方法 | 时间 |

|---|---|

| AAGCN | 91 |

| SGA-GCN | 69 |

表4 SGA-GCN模型与AAGCN线的执行时长比较(每100个执行样本) (s) |

| 方法 | 时间 |

|---|---|

| AAGCN | 11 |

| SGA-GCN | 8 |

3.3.2 多分支融合消融实验

表5 在UAV-Human数据集Csv1评估标准上,增加不同分支后的识别性能 (%) |

| 方法 | TOP-1 | TOP-5 |

|---|---|---|

| FJB | 42.90 | 64.06 |

| FJM | 42.71 | 63.52 |

| FJA | 42.65 | 64.12 |

| FBM | 41.35 | 61.74 |

| FBA | 41.05 | 63.09 |

| FMA | 40.48 | 61.82 |

| FJBM | 44.52 | 64.69 |

| FJBA | 44.20 | 64.90 |

| FBMA | 42.84 | 63.36 |

| FJBMA | 45.58 | 65.40 |

表6 在UAV-Human数据集Csv2评估标准上,增加不同分支后的识别性能 (%) |

| 方法 | TOP-1 | TOP-5 |

|---|---|---|

| FJB | 68.38 | 91.10 |

| FJM | 68.30 | 91.17 |

| FJA | 68.25 | 90.89 |

| FBM | 64.54 | 89.30 |

| FBA | 64.63 | 89.63 |

| FMA | 67.19 | 90.18 |

| FJBM | 70.86 | 91.91 |

| FJBA | 69.03 | 91.56 |

| FBMA | 69.03 | 91.50 |

| FJBMA | 71.50 | 92.45 |

3.3.3 线性插帧消融实验

表7 在UAV-Human数据集的CSV1基准上,不同的插帧方式模型TOP-1识别性能 (%) |

| 基准 | FE | RS | LI |

|---|---|---|---|

| CSV1 | 41.74 | 43.98 | 45.58 |

表8 在UAV-Human数据集CSV1基准上,不同插帧方式的不同数据分支TOP-1识别性能 (%) |

| 方式 | FJ | FB | FM | FA |

|---|---|---|---|---|

| FE | 38.6 | 38.8 | 32.2 | 35.3 |

| RS | 40.1 | 38.5 | 32.1 | 36.4 |

| LI | 40.6 | 38.8 | 32.9 | 36.8 |

3.3.4 模型评估

表9 在UAV-Hman两个评估标准上与现有方法TOP-1识别精度和参数量对比 |

| 方法 | CSV1/% | CSV2/% | 参数量(×106) |

|---|---|---|---|

| ST-GCN | 30.25 | 56.14 | 3.10 |

| DGNN | 29.90 | — | 26.24 |

| 2s-AGCN | 34.84 | 66.68 | 6.94 |

| HARD-Net | 36.97 | — | — |

| 4s-Shift-GCN | 37.98 | 67.04 | 2.76 |

| AAGCN | 41.43 | — | 3.78 |

| MS-G3D | 43.94 | — | 6.40 |

| FR-AGCN | 43.98 | 69.50 | 6.94 |

| TE-GCN | 42.50 | 68.20 | 3.10 |

| PB-GCN | 37.48 | — | 2.90 |

| MSTA-GCN | 44.32 | 70.69 | 12.00 |

| 4s-MSSTNET | 43.00 | 70.10 | 3.10 |

| SGA-GCN | 45.58 | 71.50 | 2.51 |