刮板捞渣机是水煤浆气化排渣系统中的重要组成部分。在生产过程中,刮板捞渣机可以保证除渣的效率、清洁性,有效地满足装置生产、排渣的实际需要。刮板捞渣机作为电厂生产线中极其重要的一环,其运行状态直接决定了电厂能否安全、高效地生产。因此,对捞渣机状态进行实时监测很有必要。

目前,电厂中捞渣机的状态监测主要是依靠专人定时巡检完成。当发现捞渣机出现异常情况(如:刮板与环链的连接出现断裂、捞渣机刮板严重磨损)时进行更换和检修

[1]。这种依靠大量人力和物力的人工检测方式既耗时又费力。随着计算机视觉技术的不断发展,在电厂关键设备异常检测中逐步引入基于机器学习的异常检测方法,能够有效检测设备状态。在针对电厂漏水、漏油检测方法的研究中,巩宇等

[2]在原始的YOLOv3网络基础上,提出一种多尺度特征融合的改进网络,通过提取浅层网络中更多的细粒度和深层网络中更丰富的语义信息,实现漏水、漏油目标检测,提高了模型的鲁棒性;同时在检测网络中引入Inception结构,减少模型参数量,增加网络的深度和宽度,能较好地满足电厂中漏水、漏油检测的精度和实时性要求。在针对电厂输送带设备的跑偏检测方法的研究中,胡江迪

[3]在基于语义分割网络的跑偏检测方法中,选用PSPNet模型实现输送带图像的目标分割,并通过深度学习训练得到分割后的特征图像,最后选取不同运行状态特征的输送带图像对该检测方法进行了验证。在针对电厂刀闸设备异常检测中,尤振飞等

[4]提出了一种基于语义分割与连通区域标记的隔离开关异常状态检测方法。通过使用语义分割算法提取隔离开关像素,然后使用区域生长算法的语义分割图像标记方法实现对隔离开关连通区域的标记,利用面积排序统计方法优化面积阈值并消除非开关臂的区域。最后通过引入风格迁移算法生成隔离开关风格化图像增强训练集,提升污损图像中隔离开关定位、分割的准确性。以上基于视觉的电厂关键设备检测方法均得到成功应用。

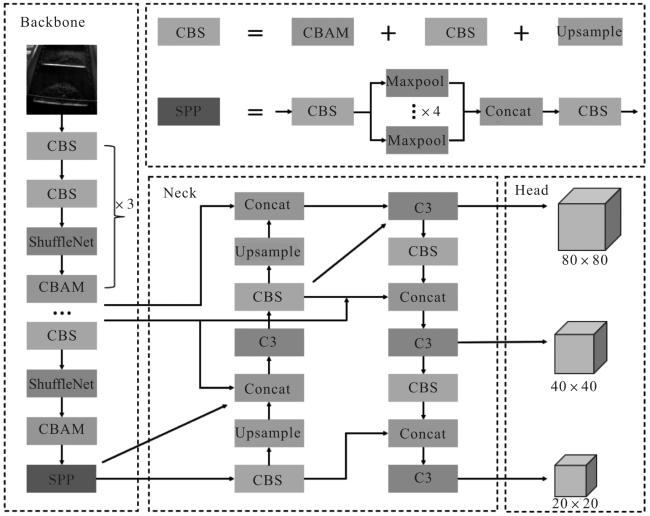

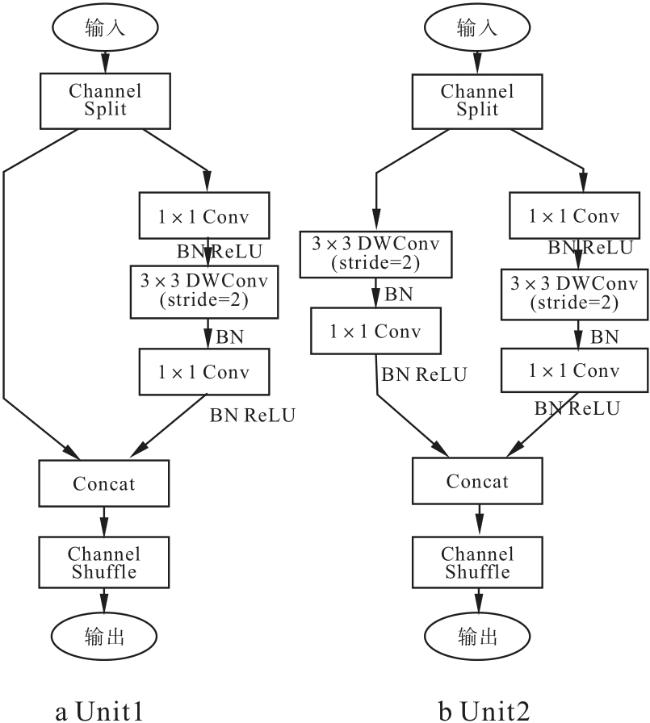

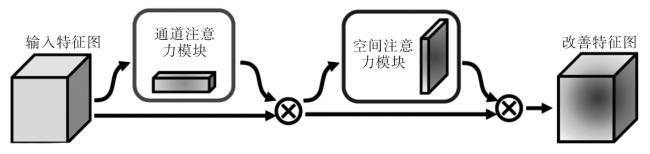

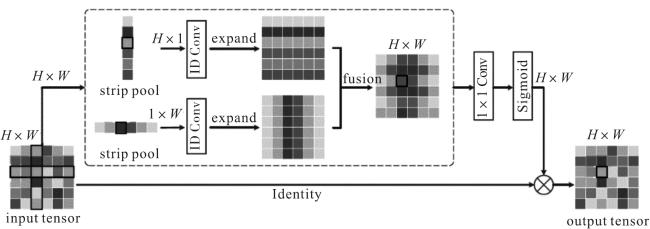

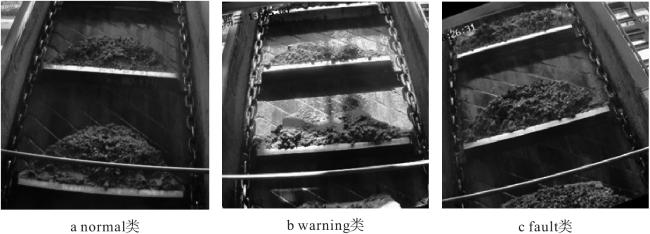

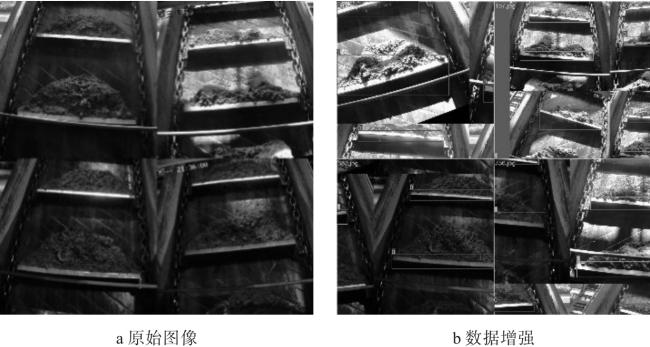

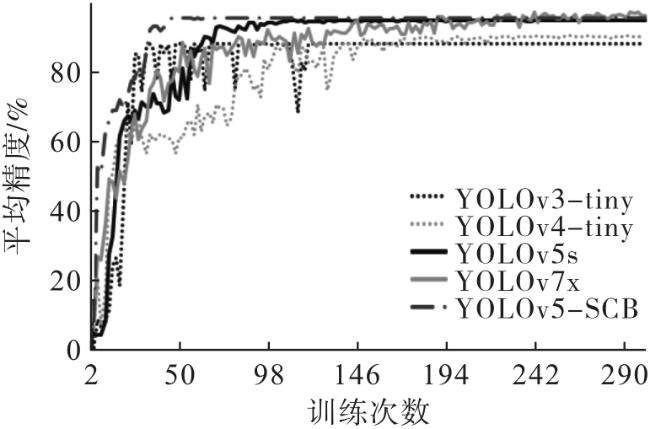

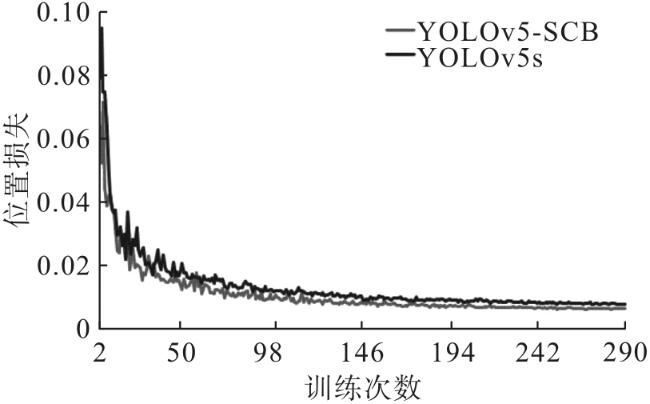

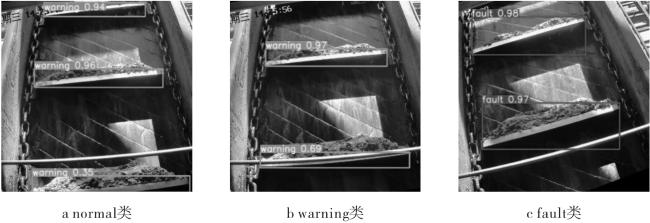

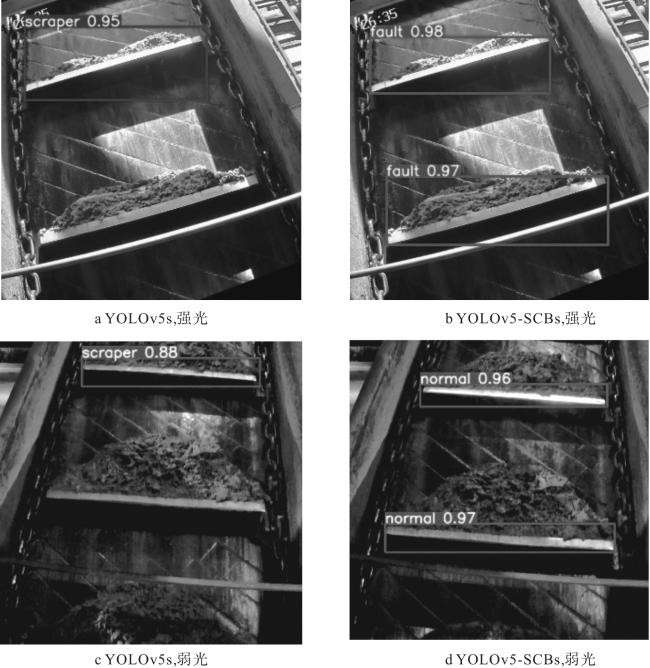

当捞渣机状态出现异常时,最直观的表现形式为刮板出现倾斜,因此将捞渣机刮板作为检测目标,根据其倾斜角度来判断捞渣机设备状态。电厂捞渣机常部署在露天环境下,现有的机器视觉检测算法易被光照变化所影响,尤其是正午阳光直射和傍晚光照强度不高时,检测算法鲁棒性不高。针对这一难题,本文以YOLOv5s网络为基础模型,首先,从网络轻量化和加快推理速度的角度引入ShuffleNet

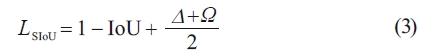

[5]和SIoU

[6]损失函数对原有模型进行改进;其次,考虑到捞渣机刮板具体的长条形状特性,引入改进的条形池化通道和空间注意力机制模块

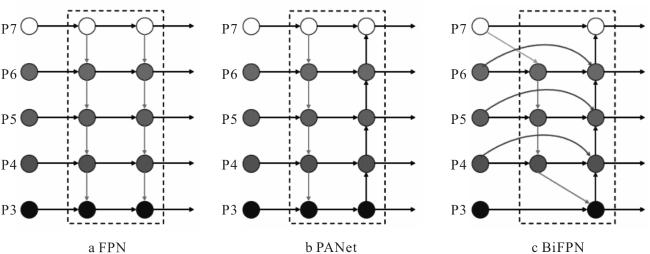

[7] (convolutional block attention module,CBAM);最后,引入加权双向特征金字塔网络

[8](bidirectional feature pyramid network,BiFPN)弥补网络轻量化造成的检测精度下降的问题,达到精度与速度的平衡;最终建立YOLOv5s-SCB模型,用于电厂捞渣机的异常状态实时精准检测。